关键词:

3月15日,腾讯AI Lab第二届学术论坛在深圳举行,聚焦人工智能在医疗、游戏、多媒体内容、人机交互等四大领域的跨界研究与应用。全球30位顶级AI专家出席,对多项前沿研究成果进行了深入探讨与交流。腾讯AI Lab还宣布了2018三大核心战略,以及同顶级研究与出版机构自然科研的战略合作(点击 这里 查看详情)。

腾讯AI Lab希望将论坛打造为一个具有国际影响力的顶级学术平台,推动前沿、原创、开放的研究与应用探讨与交流,让企业、行业和学界「共享AI+未来」。

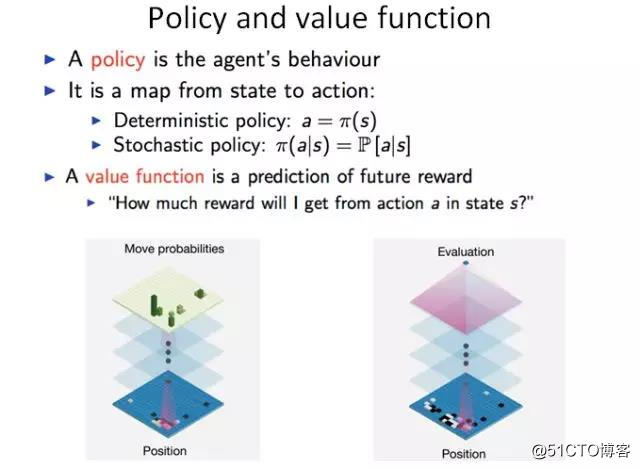

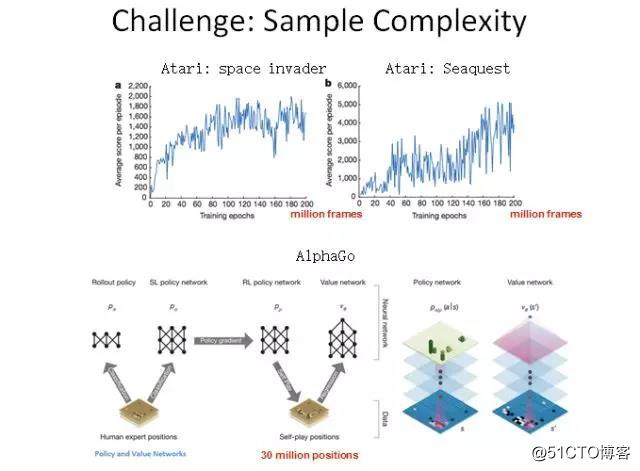

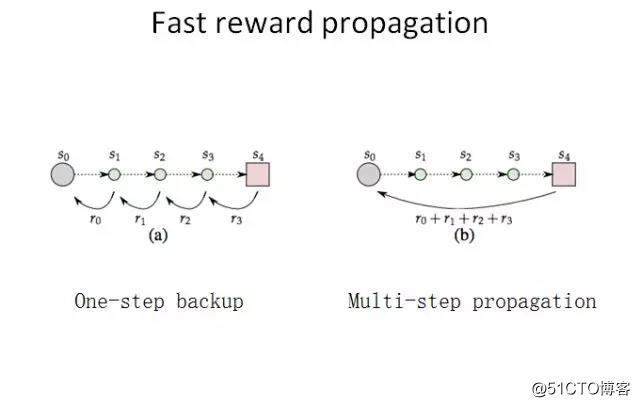

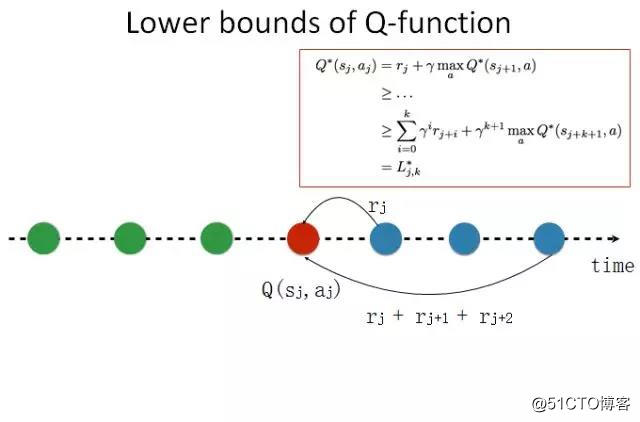

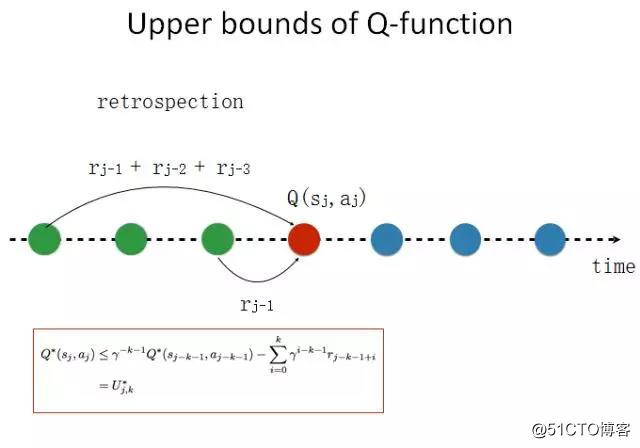

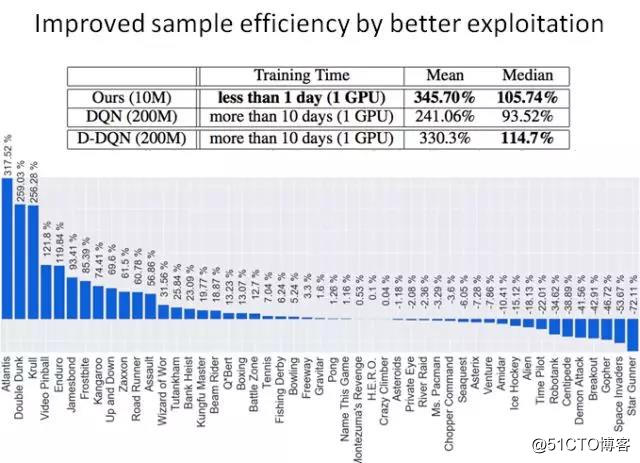

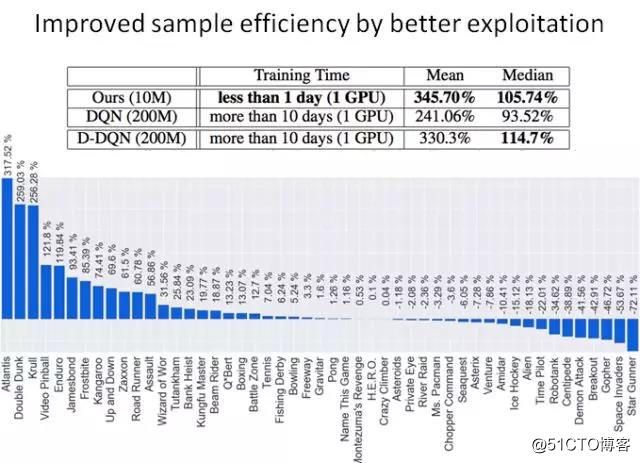

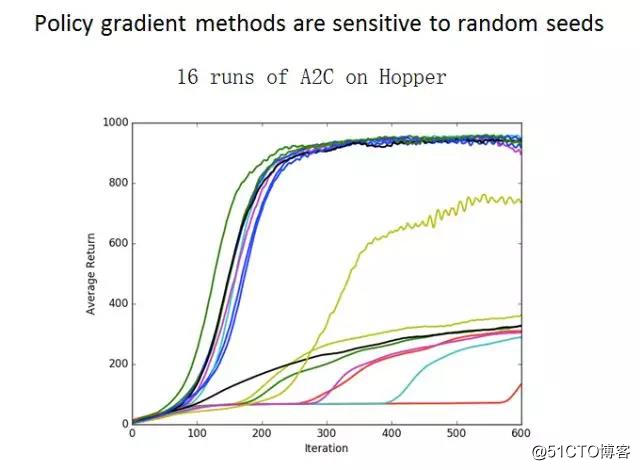

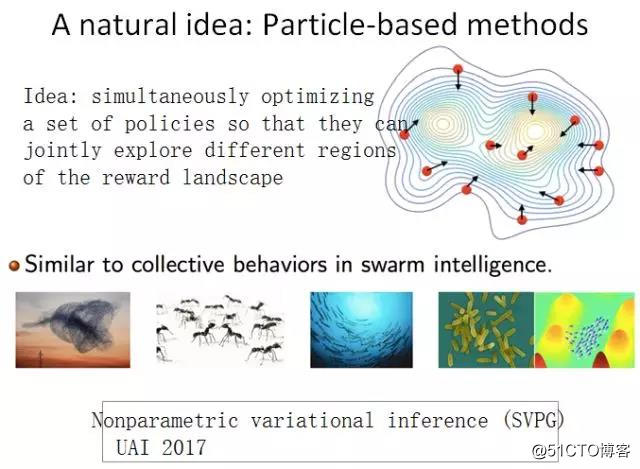

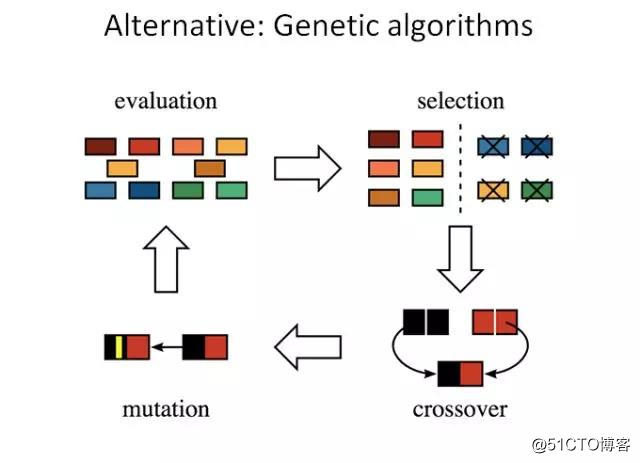

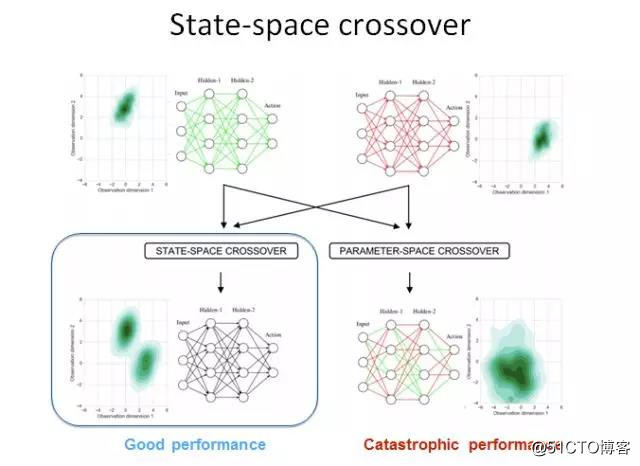

彭健 美国伊利诺伊大学厄巴纳-香槟分校计算机科学系助理教授 在下午的“AI+游戏”论坛上,美国伊利诺伊大学厄巴纳-香槟分校计算机科学系助理教授彭健博士做了主题为《实现能高效利用样本的强化学习》的演讲。 彭健博士的研究方向是计算生物学和机器学习的相关领域(如基因组、系统生物学和分子生物学方面的大数据分析处理)。在计算生物学方面,他一直致力于开发高效的算法,对庞大的基因数据集以及系统生物学和分子生物学中的数据集进行分析处理整合。在机器学习方面,他的主要研究兴趣为采样、变分推理方法以及高维图模型的结构化学习算法。他曾获得CROI青年学者奖、斯隆研究奖、美国国家自然科学基金会职业生涯奖、PhRMA基金奖等多个国际著名奖项。他是ISMB、 RECOMB、 AISTATS、ACM-BCB、 AAAI 和 GLBIO等机器学习和生物信息学会议的程序委员会会员,以及PNAS、PLOS Computational Biology、 IEEE/ACM TCB等国际顶级期刊的审稿人。彭健博士为美国芝加哥大学丰田技术学院计算机科学博士,曾于美国麻省理工学院Berger Lab进行博士后研究。 演讲内容 深度强化学习的近期进展(包括深度 Q 学习和基于神经网络的策略优化)已经证明在传统人工智能方法无法解决的很多问题上是有效的。达到人类水平的游戏智能体、AlphaGo 和机器人操作都是其中引入注目的案例。但是,这些任务策略学习需要大量的计算资源,这使得深度强化学习算法难以实际应用于计算机游戏等更复杂的任务。 本演讲将讨论一些令现有算法难以应用的挑战(尤其是奖励传播延迟、方差估计高和探索不充分),同时介绍一些解决方案,展示它们在 Atari 游戏和机车机器人任务上的应用。 以下为演讲全文(为便于阅读进行过适当编辑整理): 大家下午好,我叫彭健,来自美国伊利诺伊大学厄巴纳-香槟分校计算机系,今天我讲一讲我们研究组对深度强化学习的一些改进。 目前的游戏 AI(特别是一些基于深度学习的 AI)的表现相比传统的基于规则的算法实现了很大的提升。而且在各种各样的游戏上都有这种现象,比如控制类游戏、物理模拟类游戏(比如《愤怒的小鸟》)、基于第一视角的探索×××(比如《Minecraft》)、以及更难的有大面积搜索空间的游戏(比如《王者荣耀》、《DotA》、《星际争霸》)。另外,AlphaGo 是目前最有影响力的工作。其实所有这些游戏 AI 背后的算法都有深度强化学习。 在深度强化学习中目前有两种比较有效的算法。第一种算法是策略优化,也就是说我们通过一个函数定义智能体的一个行为,比如根据当前的游戏画面或围棋盘面定义接下来的操作。这个过程中有两种可能:一种是确定性的策略,也就是说知道下面需要走哪一步;还有一种是随机的,也就是说可能存在各种不同的选择,我可以根据概率来选择其中一个操作。策略优化方法是现在目前比较流行的方法,因为这是一种比较简单和直接的优化办法。目前主要的方法是通过策略梯度来进行优化,也就是通过优化策略来最大化未来得到的奖励(reward)。 第二种方法叫做 Q 学习,这是一种通过学习价值函数或价值网络的方法。这个价值函数能给出对未来奖励的预测。在 AlphaGo 中,这两种算法是交叉在一起的。策略网络学习下一步要走哪个子,价值函数对当前落子进行价值估计。 在目前的深度强化学习中,最大的一个难题是采样复杂度太高了,也就是说我们需要大量数据来训练我们的智能体。不论是策略优化方法还是 Q 学习的方法,都需要大量数据。比如这里展示的几个例子,在《Space Invader》和《Seaquest》这两个 Atari 游戏中,智能体所获得的分数会随训练数据增加而增加。可以看到,利用经典的深度强化学习算法可能需要 2 亿帧画面才能学到比较好的效果。AlphaGo 最早在 Nature 公布的版本也需要 3000 万个盘面。 这样高的采样复杂度,就导致我们没法在各种复杂游戏中使用深度强化学习。有两个可能的原因。第一个原因是游戏中的奖励信号通常是稀疏的或会延迟到来,也就是说我们在相当长的时间内都不会得到游戏的反馈。另一个原因可能是没有足够的探索,也就是说我们当前学习的策略可能会被困在局部最优。 下面我讲一下针对这两个问题我提出来的可能解决方案。 第一,考虑到奖励的稀疏性和延迟性问题,我们就想有没有办法可以使奖励传递得更快? 现在我们考虑一个很简单的游戏——第一视角的迷宫探索类游戏。在这个游戏中,我们只能观察到前方视野中的数据。我们的任务是从迷宫的某处出发,到达某个点。这种情况下,我们就只有一个非零奖励,也就是迷宫的出口。在探索过程中,我们不能得到任何反馈。在围棋中也是一样,我们一直要到最后一步才能知道我们是输还是赢。 在这样的情况下,我们自然会想能不能让奖励信号传播得更快一点。经典的 Q 学习算法是每次传播一步,也就是采取了一个动作就立即会有一个奖励反馈。我们很自然就会想:也许能把很多步的奖励积累起来,跨越多个时间点一次性传播回当前时间点。 下面我给大家介绍一下我的一个简单想法。假设在 Q 学习中有一个时间线,在一局游戏中不同的时间点上有不同的动作,对应不同的奖励。每个时间点都有一个价值函数 Q(sj,aj),表示在当前状态 s 时采取动作 a 的价值。经典的 Q 学习算法就是这样的,我们向下走一步,然后看能不能通过这一步的操作来更新 Q。 如果我们想实现更快的奖励传播,我们就需要向前多看若干步。这是一个很自然的想法。如果我们知道整个时间线,在当前状态,我可能对未来有一个规划和估计;如果我知道我的未来,我就可以知道当前可能会有更好的选择,我就可以得到一个对未来比较乐观的估计。我知道如果我选择一个其它动作,我能在当前时间线上得到更好的价值。这是一种展望未来式(looking forward)的算法。利用贝尔曼方程(Bellman Equation),我们可以得到当前估计的下限。 我们也可以向回看,进行一下反省。如果我们知道这样一个时间线,我们可以回到过去,我可以知道在过去的时候我可能有更好的选择。我们同样可以用贝尔曼方程展开,得到当前估计的上限。这个算法比较简单。 如图所示,上面是经典深度 Q 学习的算法,这是每一步的算法。现在我只需要对这个算法修改一点点,加两个约束——一个是基于未来的下限,一个基于过去的上限。这样我们就能大大减小价值函数的搜索空间,从而能实现更好的采样效率。 我们做了一些简单的实验。在 DeepMind 用来评价自己的算法的 64 个 Atari 游戏基准上,我们评估我们的方法的采样效率。在一个 GPU 上,经典的 DQN 算法需要 10 天以上时间才能达到与人类相当的游戏水平,而我们的算法只需要一天,而且得到的结果还更好。这个方向可能还有其它做法,这只是我们的一个尝试。 第二个问题是没有足够的探索,也就是说游戏智能体可能会困在局部最优。 比如,这是我们之前尝试的一个游戏。智能体需要探索一个迷宫,然后救出人质或达到一些其它目的。这个游戏的场景很简单,所以很容易训练。但很快在这个状态就会卡住,就无法得到一个很好的策略。 其它一些强化学习算法也会陷入类似的问题。比如在机器人学的研究中,人们利用了 A2C和 PPO 等一些其它算法。可以看到,如果用同样的算法训练同样的游戏若干次,不同的次数可能就会得到非常不同的训练结果。这是因为策略优化和 DQN 算法很容易陷入局部最优,而且我们不知道它们什么时候能跳出来。 所以我们就想,如果只训练一个模型容易陷入局部最优,那么我们就训练多个模型。这个算法与自然界采用的一些方法很像,比如蚁群算法和其它一些组合优化算法。我们可以同时采取多个不同的模型,同时进行训练。我们的目标是同时优化这些模型的表现,同时让这些模型看起来不太一样。基于这一思考,我们首先提出一种名叫非参数变分推理(SVPG)的算法,这个工作发表在 UAI 2017 会议上。 另一个比较直观的想法是用遗传算法。我们通过经典的遗传算法,同时维护若干个模型,然后让这些模型分别自己进化并进行杂交。之后我们选取其中更好的后代进行优化。针对深度强化学习,我们设计了一个新的基于神经网络的 crossover 优化器。也就是说,当我们有一个父亲模型和一个母亲模型的时候,我们可以怎样得到一个比较好的后代模型? 我们用了一个不同于传统的方法。我们用模仿学习(imitation learning)方法训练一个后代,让它去模拟父亲和母亲的策略行为。然后我们在一些机器人环境中探索了这些算法的优异性。我们的算法在大多数机器人任务上都能超越之前的最佳方法。 我刚才介绍了针对探索和奖励延迟问题的一些解决方法。而深度强化学习还有很多其它问题。如果我们想利用深度强化学习设计比较复杂的游戏 AI,可能就会遇到很多难题。比如,第一个问题可能是策略梯度估计时方差比较大——我们做了一些优化这个方差的工作。第二个问题是动作空间比较大,我们需要一些抽象(abstraction)方法来缩小动作空间。第三个问题是现在的算法的数据有效性还是不够,我们需要一些更好的优化算法。 谢谢!

腾讯游戏ai可以诊断疾病;妄议马斯克?员工遭解雇后再起诉;geohot任职twitter5.5周后离职...

本周,有哪些AI新鲜事?产业界把游戏AI用于疾病诊断,腾讯AILab研究成果登上国际顶会12月19日,腾讯AILab发布其决策智能AI“绝悟”的最新成果“绝悟RLogist”,将AI深度强化学习技术迁移到病理全片扫描图像诊... 查看详情

用ai助力生命科学研究,腾讯ailab三项成果登上国际顶级学术期刊

...和空间嵌入的空间转录组细胞类型注释方法Spatial-ID一种利用空间组学数据进行微环境建模的通用方法SOTIP一个超过5000万细胞、26个种类的空间组学数据库在空间组学相关技术上,腾讯AILab的核心攻坚方向和优势在于AI算法研究... 查看详情

腾讯副总裁姚星:腾讯ailab将致力打造通往agi之路

...AILab第二届学术论坛在深圳举行,聚焦人工智能在医疗、游戏、多媒体内容、人机交互等四大领域的跨界研究与应用。全球30位顶级AI专家出席,对多项前沿研究成果进行了深入探讨与交流。今天,腾讯副总裁姚星在腾讯AILab主办... 查看详情

利用ai强化学习训练50级比卡超单挑70级超梦!(代码片段)

...#xff08;agent)做任何事——从行走到玩Pong或围棋之类的游戏都在范围中。这次我会仿照Gym的游戏模式,再根据pokemon官网给出的战斗数据,创建一个pokemon的对战系统,再利用强化学习训练50级比卡超单挑70级超梦。如... 查看详情

利用ai强化学习训练50级比卡超单挑70级超梦!(代码片段)

...#xff08;agent)做任何事——从行走到玩Pong或围棋之类的游戏都在范围中。这次我会仿照Gym的游戏模式,再根据pokemon官网给出的战斗数据,创建一个pokemon的对战系统,再利用强化学习训练50级比卡超单挑70级超梦。如... 查看详情

腾讯技术工程|腾讯ailab11篇论文精选:图像描述nmt模型图卷积神经网络等

...中的特定翻译问题、自适应图卷积神经网络、DNN面对对抗样本的优化问题等,本文精选了11篇论文的精彩内容。(本文转自公众号新智元)1.学习用于图像描述的引导解码(LearningtoGuideDecodingforImageCaptioning) 查看详情

中科大教授吴锋:多智能体的分布式在线决策|腾讯ailab学术论坛演讲

...AILab第二届学术论坛在深圳举行,聚焦人工智能在医疗、游戏、多媒体内容、人机交互等四大领域的跨界研究与应用。全球30位顶级AI专家出席,对多项前沿研究成果进行了深入探讨与交流。腾讯AILab还宣布了2018三大核心战略,以... 查看详情

腾讯技术工程|腾讯ailab解析2017nips三大研究方向,启动教授及学生合作项目

...情况,并简介了腾讯AILab入选的八篇论文。NIPS被誉为机器学习和人工智能研究领域最具影响力,也是参会人数最多的的学术会议。腾讯AILab去年4月成立,今年第二次参加NIPS,共有8篇文章被录取,含一篇 查看详情

用上强化学习和博弈论,ea开发的测试ai成精了

...后到达终点……你以为这是个类似于微信“跳一跳”的小游戏?但它的真实身份,其实是游戏大厂EA(美国艺电公司)最新研究出的游戏测试AI。和普通只会打游戏的AI不同,这次EA提出的新模型不仅要让小人成... 查看详情

腾讯面试——ai岗

(1)腾讯TEG提前批二面挂:一面:项目+扩展机器学习的基础知识(k-means,svm,LBP算子,mobilnetv2和v1的区别,主流的网络)+一个代码题二面:项目+基础知识:这次面试失败是我拿到后面offer的关键,有一个问题我在后面被反复... 查看详情

筹备两年,60万字诚意续作《腾讯游戏开发精粹ⅱ》正式发布

2019年,腾讯游戏学堂联合多名技术专家,整理沉淀前沿技术方案,出版《腾讯游戏开发精粹》,受到了行业的关注和认可。经过2年筹备,《腾讯游戏开发精粹Ⅱ》正式发布,收录21个在上线项目中得到验... 查看详情

每日一书丨筹备两年,60万字诚意续作《腾讯游戏开发精粹ⅱ》正式发布

2019年,腾讯游戏学堂联合多名技术专家,整理沉淀前沿技术方案,出版《腾讯游戏开发精粹》,受到了行业的关注和认可。经过2年筹备,《腾讯游戏开发精粹Ⅱ》正式发布,收录21个在上线项目中得到验... 查看详情

让机器像人类一样学习?

...种可以参考的方法。使用这一范式,智能体可以通过充分利用在执行相关任务中积累的丰富经验,以这些有限的数据为基础去适应新的任务。针对这类既需要采取行动又需要积累过往经验的智能体来说,元强化学习可以帮助其快... 查看详情

深度强化学习curriculum-guidedhindsightexperiencereplay读后感

目录导读目录正文Abstract【摘要】Introduction【介绍】导读看任何一个领域的文章,一定要看第一手资料。学习他们的思考方式,论述逻辑,得出一点自己的感悟。因此,通过阅读paper,来提升自己对于这个领域的感性和理性认识。... 查看详情

eccv2018|ubc&腾讯ailab提出首个模块化gan架构,搞定任意图像ps组合

...。不同的模块可以在测试时轻松组合,以便在不同的域中高效地生成/转换图像。研究者称,这是首个模 查看详情

使用深度q学习的ai驱动蛇游戏源码分享(代码片段)

在构建基本的蛇游戏之后,现在我们将专注于如何将强化学习应用于它。我们必须在这个项目中创建三个模块:1.环境(我们刚刚构建的游戏)2.模型(移动预测的强化模型)3.代理(环境和模型之间的... 查看详情

从研究到应用:腾讯ailab的自然语言理解和生成

...能通过计算和逻辑。因此,自然语言的理解需要通过表征学习(RepresentationLearning)的手 查看详情

强化学习:概述

...分为监督和无监督,所谓监督即是否有外在的标准来约束样本,也就是所谓的标签;无监督则是没有标签的样本。强化学习之所以认为是机器学习的一种架构,是基于强 查看详情