关键词:

- flume 监控hive 日志文件

一: flume 监控hive的日志

1.1 案例需求:

1. 实时监控某个日志文件,将数据收集到存储hdfs 上面, 此案例使用exec source ,实时监控文件数据,使用Memory Channel 缓存数据,使用HDFS Sink 写入数据

2. 此案例实时监控hive 日志文件,放到hdfs 目录当中。

hive 的日志目录是

hive.log.dir = /home/hadoop/yangyang/hive/logs1.2 在hdfs 上面创建收集目录:

bin/hdfs dfs -mkdir /flume 1.3 拷贝flume 所需要的jar 包

cd /home/hadoop/yangyang/hadoop/

cp -p share/hadoop/hdfs/hadoop-hdfs-2.5.0-cdh5.3.6.jar /home/hadoop/yangyang/flume/lib/

cp -p share/hadoop/common/hadoop-common-2.5.0-cdh5.3.6.jar

/home/hadoop/yangyang/flume/lib/

cp -p share/hadoop/tools/lib/commons-configuration-1.6.jar

/home/hadoop/yangyang/flume/lib/

cp -p share/hadoop/tools/lib/hadoop-auth-2.5.0-cdh5.3.6.jar /home/hadoop/yangyang/flume/lib/

1.4 配置一个新文件的hive-test.properties 文件:

cp -p test-conf.properties hive-conf.propertiesvim hive-conf.properties

# example.conf: A single-node Flume configuration

# Name the components on this agent

a2.sources = r2

a2.sinks = k2

a2.channels = c2

# Describe/configure the source

a2.sources.r2.type = exec

a2.sources.r2.command = tail -f /home/hadoop/yangyang/hive/logs/hive.log

a2.sources.r2.bind = namenode01.hadoop.com

a2.sources.r2.shell = /bin/bash -c

# Describe the sink

a2.sinks.k2.type = hdfs

a2.sinks.k2.hdfs.path = hdfs://namenode01.hadoop.com:8020/flume/%Y%m/%d

a2.sinks.k2.hdfs.fileType = DataStream

a2.sinks.k2.hdfs.writeFormat = Text

a2.sinks.k2.hdfs.batchSize = 10

# 设置二级目录按小时切割

a2.sinks.k2.hdfs.round = true

a2.sinks.k2.hdfs.roundValue = 1

a2.sinks.k2.hdfs.roundUnit = hour

# 设置文件回滚条件

a2.sinks.k2.hdfs.rollInterval = 60

a2.sinks.k2.hdfs.rollsize = 128000000

a2.sinks.k2.hdfs.rollCount = 0

a2.sinks.k2.hdfs.useLocalTimeStamp = true

a2.sinks.k2.hdfs.minBlockReplicas = 1

# Use a channel which buffers events in memory

a2.channels.c2.type = memory

a2.channels.c2.capacity = 1000

a2.channels.c2.transactionCapacity = 100

# Bind the source and sink to the channel

a2.sources.r2.channels = c2

a2.sinks.k2.channel = c2 1.5 运行agent 处理

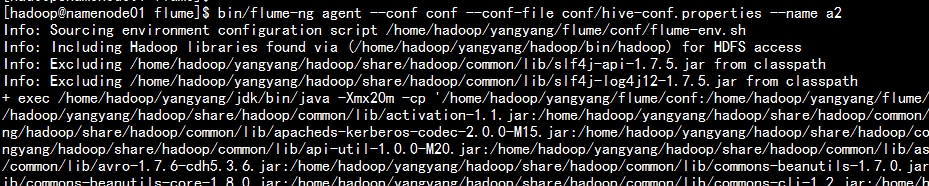

bin/flume-ng agent --conf conf --conf-file conf/hive-conf.properties --name a2

1.6 写入hive 的log日志文件测试:

cd /home/hadoop/yangyang/hive/logs

echo "111" >> hive.log

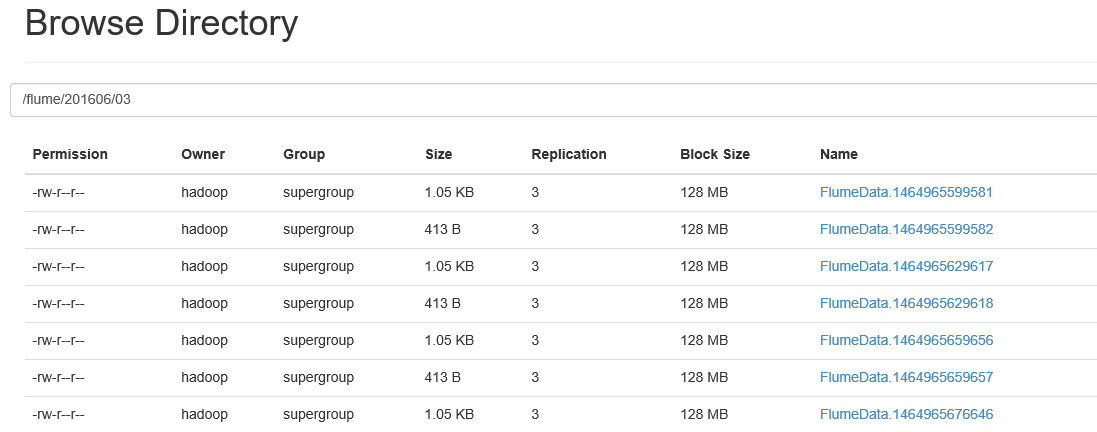

每隔一段时间执行上面的命令测试1.7 去hdfs 上面去查看:

学习笔记--hive网站日志统计分析(代码片段)

...置好flume、hadoop、hivehive安装配置hadoop安装配置数据源nginx日志文件access.log需修改nginx日志输出 查看详情

flume监控目录操作(代码片段)

flume监控目录操作一:flume监控目录操作文件需求:监控某个目录,若目录下面产生成符合条件的文件,flume就抽取它到hdfs上,目录下可能有多中文件,比如当文件以log.tmp结尾表示正在写,对log.tmp文件设置size值,就会变成一个... 查看详情

hadoop详解——hive的原理和安装配置和udf,flume的安装和配置以及简单使用,flume+hive+hadoop进行日志处理(代码片段)

hive简介什么是hive?①hive是建立在Hadoop上的数据仓库基础架构。它提供了一系列的工具,可以用来进行数据提取转换加载(ETL),这是一种可以存储、查询和分析存储在Hadoop中的大规模数据的机制。hive定义了简单的类似... 查看详情

hadoop详解——hive的原理和安装配置和udf,flume的安装和配置以及简单使用,flume+hive+hadoop进行日志处理(代码片段)

hive简介什么是hive?①hive是建立在Hadoop上的数据仓库基础架构。它提供了一系列的工具,可以用来进行数据提取转换加载(ETL),这是一种可以存储、查询和分析存储在Hadoop中的大规模数据的机制。hive定义了简单的类似... 查看详情

flume-ng+hdfs+hive日志收集分析(代码片段)

最近做了一个POC,目的是系统日志的收集和分析,此前有使用过splunk,虽然用户体验很好,但一是价格昂贵,二是不适合后期开发(splunk已经推出了SDK,后期开发已经变得非常容易)。在收集TB级别的日志量上flume-ng是更好的选... 查看详情

flume(代码片段)

...概述第2章Flume快速入门2.1Flume安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件2.2.3实时监控目录下多个新文件2.2.4实时监控目录下的多个追加文件第3章Flume进阶3.1Flume事务3.2FlumeAgent内部原理3.3Flume拓扑... 查看详情

flume(代码片段)

...概述第2章Flume快速入门2.1Flume安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件2.2.3实时监控目录下多个新文件2.2.4实时监控目录下的多个追加文件第3章Flume进阶3.1Flume事务3.2FlumeAgent内部原理3.3Flume拓扑... 查看详情

实时监听hive日志文件,并将内容打印到控制台上

1:在flume/job下配置flume-file-logger.conf配置文件 2:在flume根目录下开启监听(注意,如果当天没有使用hive产生过日志文件的话先操作hive产生当天日志文件) 3:操作hive产生日志文件,查看控制台 查看详情

flume+kafka+sparkstreaming+hbase+可视化(代码片段)

...量,再传到Hdfs:实效性不高,容错率低,网络/磁盘IO,监控2、Flume:Flume:关键在于写配置文件1)配置age 查看详情

flume(代码片段)

...lume安装部署2.1.1安装地址2.1.2安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件-exec2.2.3实时监控目录下多个新文件-spooldir 查看详情

flume(代码片段)

...lume安装部署2.1.1安装地址2.1.2安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件-exec2.2.3实时监控目录下多个新文件-spooldir 查看详情

大数据技术之flumeflume概述flume快速入门(代码片段)

...lume安装部署2.1.1安装地址2.1.2安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件2.3.3实时监控目录下多个新文件2.2.4实时监控目录下的多个追加文件1Flume概述1.1Flume定义Flume是Cloudera提供的一个高可用的&#x... 查看详情

大数据技术之flumeflume概述flume快速入门(代码片段)

...lume安装部署2.1.1安装地址2.1.2安装部署2.2Flume入门案例2.2.1监控端口数据官方案例2.2.2实时监控单个追加文件2.3.3实时监控目录下多个新文件2.2.4实时监控目录下的多个追加文件1Flume概述1.1Flume定义Flume是Cloudera提供的一个高可用的&#x... 查看详情

日志采集flume配置(代码片段)

Flume直接读log日志的数据,log日志的格式是app.yyyy-mm-dd.logFlume的具体配置在/opt/module/flume/conf目录下创建file-flume-kafka.conf文件[hadoop@hadoop102conf]$vimfile-flume-kafka.conf在文件配置如下内容#为各组件命名a1.sources=r1a1.c 查看详情

日志采集flume配置(代码片段)

Flume直接读log日志的数据,log日志的格式是app.yyyy-mm-dd.logFlume的具体配置在/opt/module/flume/conf目录下创建file-flume-kafka.conf文件[hadoop@hadoop102conf]$vimfile-flume-kafka.conf在文件配置如下内容#为各组件命名a1.sources=r1a1.c 查看详情

13-flume(代码片段)

...负责接收数据 Source类型:SpoolingDirectorySource(监控目录)、监控文件、NetcatSource(监控端口)、exec(监控控制台)等 ④Channel: ①Channel被设计为event中转暂存区,存储Source收集并且没有被Sink消费的event... 查看详情

flume(代码片段)

...安装解压安装包更改配置文件flume-env.sh,添加JAVA_HOME变量监控端口数据案例使用Flume监控本机44444端口,通过telnet工具向端口44444发送数据,Flume将监听的数据实时显示在控制台。1.通过telnet工具向端口44444发送数据telnetlocalhost444442... 查看详情

flume日志收集(代码片段)

1、flume日志收集架构如下 2、解压安装包,修改文件夹名称,配置环境变量tar-zxvfapache-flume-1.6.0-bin.tar.gz exportFLUME_HOME=/soft/flume exportPATH=$PATH:$FLUME_HOME/bin修改conf下的flume-env.sh,在里面配置JAVA_HOME3 查看详情